Microsoft는 언어 모델 분야에서 흥미롭고 새로운 개발인 1비트 LLM을 출시했습니다. 이번 발전은, BitNet과 같은 연구 프로젝트에서 영감을 얻었습니다., 언어 모델이 구성되고 최적화되는 방식에 눈에 띄는 변화가 있음을 나타냅니다. 이 혁신의 중심에는 모델 매개변수(또는 가중치)를 나타내는 놀랍도록 효율적인 방법이 있습니다.기존 16비트 부동 소수점(FP16)과 달리 단 1.58비트만 사용 이전 모델에서 널리 사용되는 접근 방식입니다.

최초의 1비트 LLM

더빙 비트넷 LLM b1.58이 선구적인 접근 방식은 각 가중치의 잠재적 값을 단 세 가지 옵션으로 제한합니다. -1, 0 또는 +1. 매개변수당 필요한 비트 수의 극적인 감소는 이 획기적인 기술의 기반을 설정합니다. 놀랍게도 비트 소모량이 적음에도 불구하고 BitNet b1.58은 기존 모델과 비슷한 성능 지표를 제공합니다. 여기에는 동일한 크기와 훈련 데이터 세트를 사용하면서 복잡성 및 최종 작업 성능과 같은 영역이 포함됩니다.

1비트 LLM이란 무엇입니까?

생성 AI 장면은 나날이 발전하고 있습니다., 그리고 이 역동적인 분야의 최신 혁신은 1비트 언어 학습 모델의 출현입니다. 놀랍게 들릴 수도 있지만, 이러한 개발은 오늘날 LLM이 직면한 가장 중요한 장애물 중 일부를 해결함으로써 AI 분야를 변화시킬 수 있는 잠재력을 가지고 있습니다.즉, 그들의 거대한 크기입니다.

일반적으로 LLM이든 로지스틱 회귀와 같은 간단한이든 관계없이 기계 학습 모델의 가중치는 다음 중 하나를 사용하여 저장됩니다. 32비트 또는 16비트 부동 소수점. 이 표준 접근 방식은 양날의 검입니다. 이는 모델 계산의 높은 정밀도를 허용하는 동시에 이러한 모델의 크기도 엄청나게 커집니다.

이러한 부풀림은 로컬 시스템이나 프로덕션 환경에 GPT와 같은 헤비급 챔피언을 배포하는 것이 물류상의 악몽이 되는 이유입니다. 이러한 부동 소수점의 정밀도에 필요한 천문학적인 무게의 수는 크기를 관리할 수 없을 정도로 부풀립니다.

기존 모델들과는 확연히 대조되는, 1비트 LLM은 단일 비트(0 또는 1)만 사용하여 가중치 매개변수를 나타냅니다. 사소해 보이는 이 조정에는 중요한 의미가 있습니다. 즉, 잠재적으로 엄청난 차이로 모델의 전체 크기를 극적으로 줄입니다.

이러한 크기 감소는 다음과 같은 배포의 길을 열어줍니다. 훨씬 작은 장치의 LLM고급 AI 애플리케이션을 더욱 다양한 플랫폼에서 접근 가능하고 실행 가능합니다.

BitNet LLM b1.58로 돌아가기

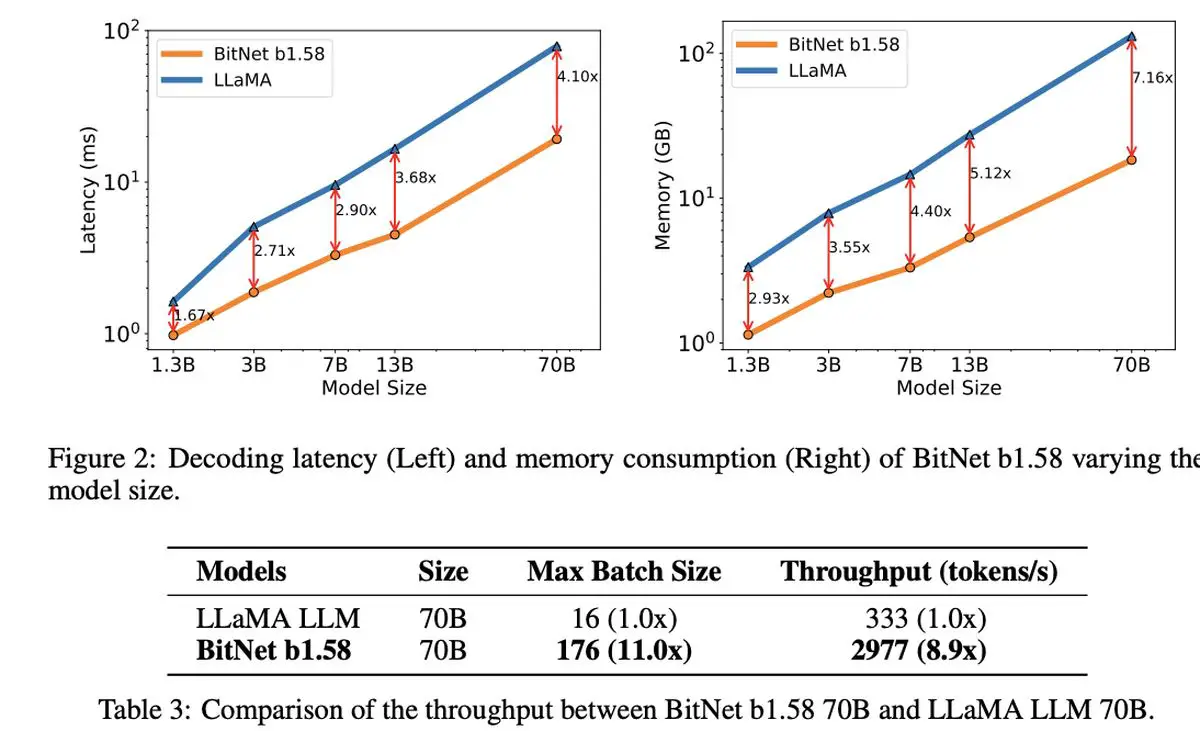

1.58비트 LLM의 정말 놀라운 점은 비용 효율성. 이 모델은 대기 시간 감소, 메모리 사용량 감소, 처리량 향상, 에너지 소비 감소 측면에서 빛을 발하며 계산 집약적인 AI 세계에서 지속 가능한 옵션을 제시합니다.

마이크로소프트의 1비트 LLM 효율성만 뛰어난 것이 아닙니다. 이는 언어 모델 확장 및 학습에 대한 새로운 관점을 나타내며, 최고의 성능과 경제적 실행 가능성의 균형을 유지합니다. 이는 새로운 컴퓨팅 패러다임의 시작과 이러한 더 간결하고 효율적인 모델을 실행하기 위해 맞춤화된 특수 하드웨어를 만들 수 있는 가능성을 암시합니다.

BitNet LLM b1.58에 대한 토론도 열립니다. LLM에서 긴 시퀀스를 보다 효과적으로 관리할 수 있는 흥미로운 가능성추가 연구를 위한 잠재적인 영역을 제안 무손실 압축 기술을 사용하여 효율성을 더욱 높입니다.

이러한 주목할만한 혁신의 그늘에서 Microsoft는 최신 소형 언어 모델인 Phi-2를 출시하여 파장을 일으키고 있습니다. 매개변수가 27억 개에 이르는 이 강력한 기업은 이해와 추론에 있어 뛰어난 능력을 보여주었으며, 이는 AI 기술의 경계를 넓히려는 Microsoft의 지속적인 노력을 보여주는 추가 증거입니다. Phi-2의 성공과 함께 1비트 LLM의 도입은 언어 모델 개발에서 혁신과 효율성의 흥미진진한 시대를 강조할 것입니다.

주요 이미지 출처: Drew Beamer/Unsplash

Source: Microsoft, 1비트 LLM 출시